Instagram подтвердили, что удаляют контент, который наносит вред ментальному здоровью пользователей. Удаление стало одним из шагов работы проекта по сокращению вредоносного контента на платформе после смерти 14-летней Молли Рассел. Британский подросток покончила с собой в 2017 году после просмотров постов в соцсети, связанных с самоповреждениями, депрессией и самоубийством. Близкие Молли считают, что алгоритмы соцсети показывали девушке опасный контент и часть вины за смерть подростка лежит на корпорации Facebook, которой принадлежит Instagram.

Ситуация с Молли не единственный случай. Так, в 2016 году 16-летняя девушка из Малайзии покончила с собой после того, как провела опрос в своем инстаграме, стоит ли ей жить.

После трагических случаев представители соцсети заявили, что удвоили контроль над изображениями, рисунками, аниме и мемами, которые изображают самоповреждение или самоубийство.

Глава Instagram Адам Моссери прокомментировал: "Для полного внедрения потребуется время, но это не будет последним шагом, который мы сделаем".

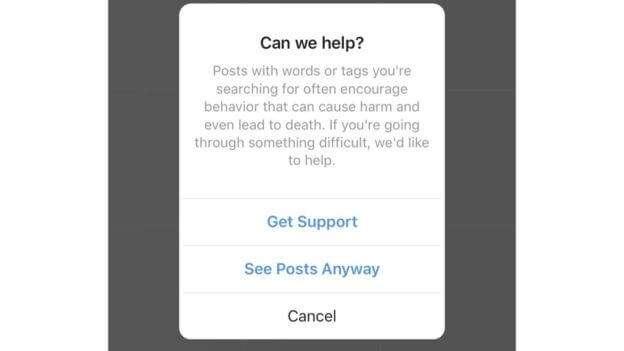

Ранее в этом году на платформе запустили "экраны чувствительности", которые размывают любые потенциально опасные изображения - хотя они могут быть показаны, если пользователи захотят их просмотреть. Также в соцсети уже блокируют хештеги, учетные записи и целенаправленные поисковые термины, связанные с самоповреждением и самоубийством.

Моссери также рассказал, что Instagram разрабатывают программу и хотят "поддерживать людей, которые публикуют изображения, указывающие, что они испытывают психологические трудности".

В Instagram сообщают, что с первого квартала 2019 года количество удаленных материалов, связанных с причинением вреда себе и самоубийством, удвоилось. В период с апреля по июнь этого года было удалено 834 000 единиц контента, 77% из которых не было сообщено пользователями.

Читайте также: В инстаграме вышел IGTV-сериал о подростковом буллинге